14 Fév Quand la physique des particules et l’intelligence artificielle entrent en collision

Une recherche charnière effectuée par des scientifiques de l’Institut Weizmann utilise l’intelligence artificielle pour percer les mystères de particules qui entrent en collision.

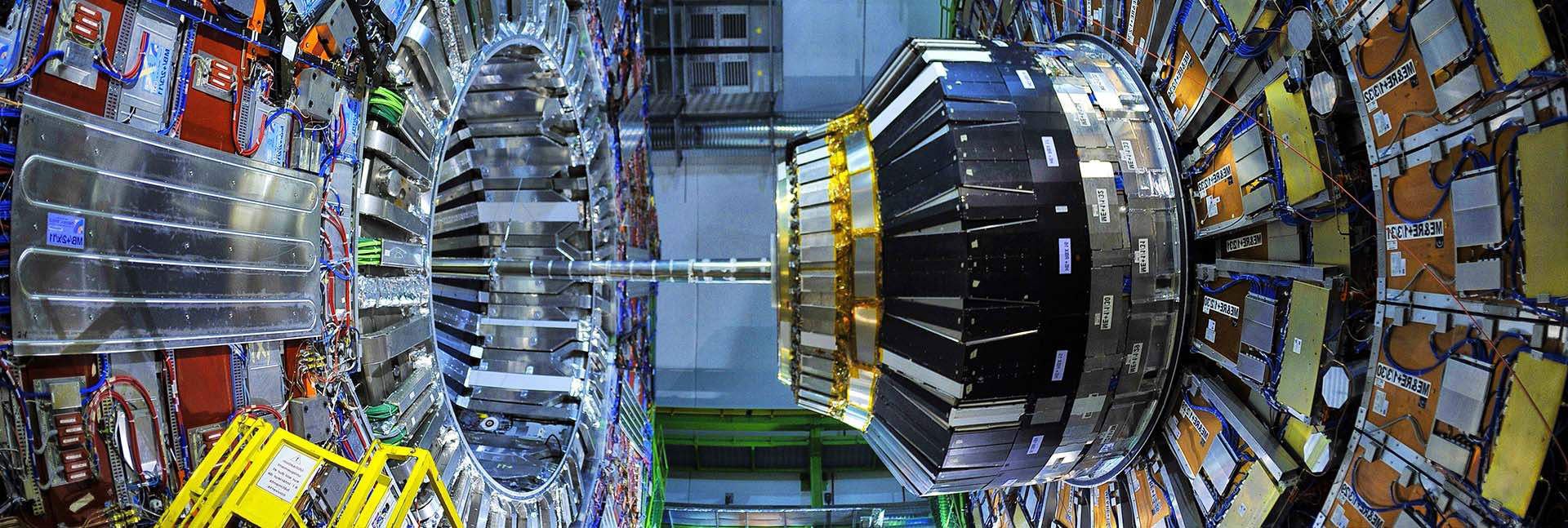

« Notre travail est similaire à l’inspection des restes d’un accident d’avion où nous essayons de reconstituer la couleur du pantalon que portait le passager du siège A17 », explique Jonathan Shlomi, un doctorant du groupe du professeur Eilam Gross du Département de Physique des Particules et d’Astrophysique de l’Institut Weizmann des Sciences. Mais au lieu d’un endroit au milieu de l’océan ou d’un orage au sommet d’une montagne, J.Shlomi fait en réalité référence au célèbre Grand Collisionneur de Hadrons (LHC) du CERN, où les particules en collision sont comparées à un avion qui s’écrase.

Le Prof. Gross n’est pas étranger à l’accélérateur de particules du CERN. Entre 2011 et 2013, il a dirigé une équipe de chercheurs à la recherche du boson de Higgs, à l’aide du détecteur ATLAS ; son groupe était l’un des deux qui ont annoncé la découverte de la particule insaisissable en juillet 2012. La découverte du boson de Higgs, souvent appelé « particule de Dieu », a marqué la solution d’une énigme physique vieille de plusieurs décennies : comment les particules acquièrent-elles une masse ? Selon le modèle prédit par Peter Higgs et François Englert dans les années 1960, cette particule est le principal coupable. Cependant, cette particule est restée une entité théorique jusqu’en 2012, malgré de nombreuses tentatives de détection. Contre toute attente, la particule a été découverte, l’énigme a été résolue, et en 2014, le Prof. Gross est retourné en Israël. Mais après avoir contribué à résoudre l’une des plus grandes questions de la physique moderne, que restait-il à étudier pour le Prof. Gross ?

(de gauche à droite) Sanmay Ganguly, Dmitrii Kobylianskii, Anton Charkin-Gorbulin, le professeur Eilam Gross, Nilotpal Kakati, Jonathan Shlomi et Anna Ivina. Suivre le courant

La voie évidente à suivre en physique des particules, ou des hautes énergies, est la découverte d’une particule inconnue ou de toute autre caractéristique nouvelle du monde subatomique. Après la découverte de la « particule de Dieu », les efforts du CERN se sont concentrés sur la démonstration d’autres modèles théoriques tels que la supersymétrie, selon laquelle chaque boson devrait avoir son superpartenaire fermion et vice versa. Toutefois, ces efforts étant dans l’impasse, le Prof. Gross s’est rendu compte qu’il était peut-être temps d’emprunter une nouvelle voie : améliorer et affiner les méthodes actuelles d’analyse des données afin d’améliorer à la fois l’extraction des données existantes et l’efficacité de la recherche de nouvelles particules dans les accélérateurs actuels et futurs. Pour y parvenir, le Prof. Gross a créé un nouveau groupe de recherche à l’Institut Weizmann, qui se concentre sur la résolution de questions majeures en physique des particules à l’aide d’approches d’apprentissage automatique. J. Shlomi a été le premier étudiant à rejoindre le groupe, et il a immédiatement entrepris la mission d’améliorer l’analyse de l’ensemble des données du détecteur ATLAS, qui contient quelque 100 millions de composants.

Lorsque des particules entrent en collision dans le détecteur ATLAS, ses composants enregistrent des mesures d’énergie que les scientifiques doivent ensuite déchiffrer. Si l’on ajoute à cela le fait qu’il y a plus d’un milliard de collisions par seconde pendant le fonctionnement de l’accélérateur, cette configuration pose un problème à deux volets : d’une part, la quantité stupéfiante de données ne peut être analysée manuellement ; d’autre part, comme il s’agit d’événements qui évoluent rapidement à l’échelle microscopique, le nombre de composants du détecteur – aussi grand soit-il – ne permet pas de recueillir efficacement tous les événements au même niveau de précision.

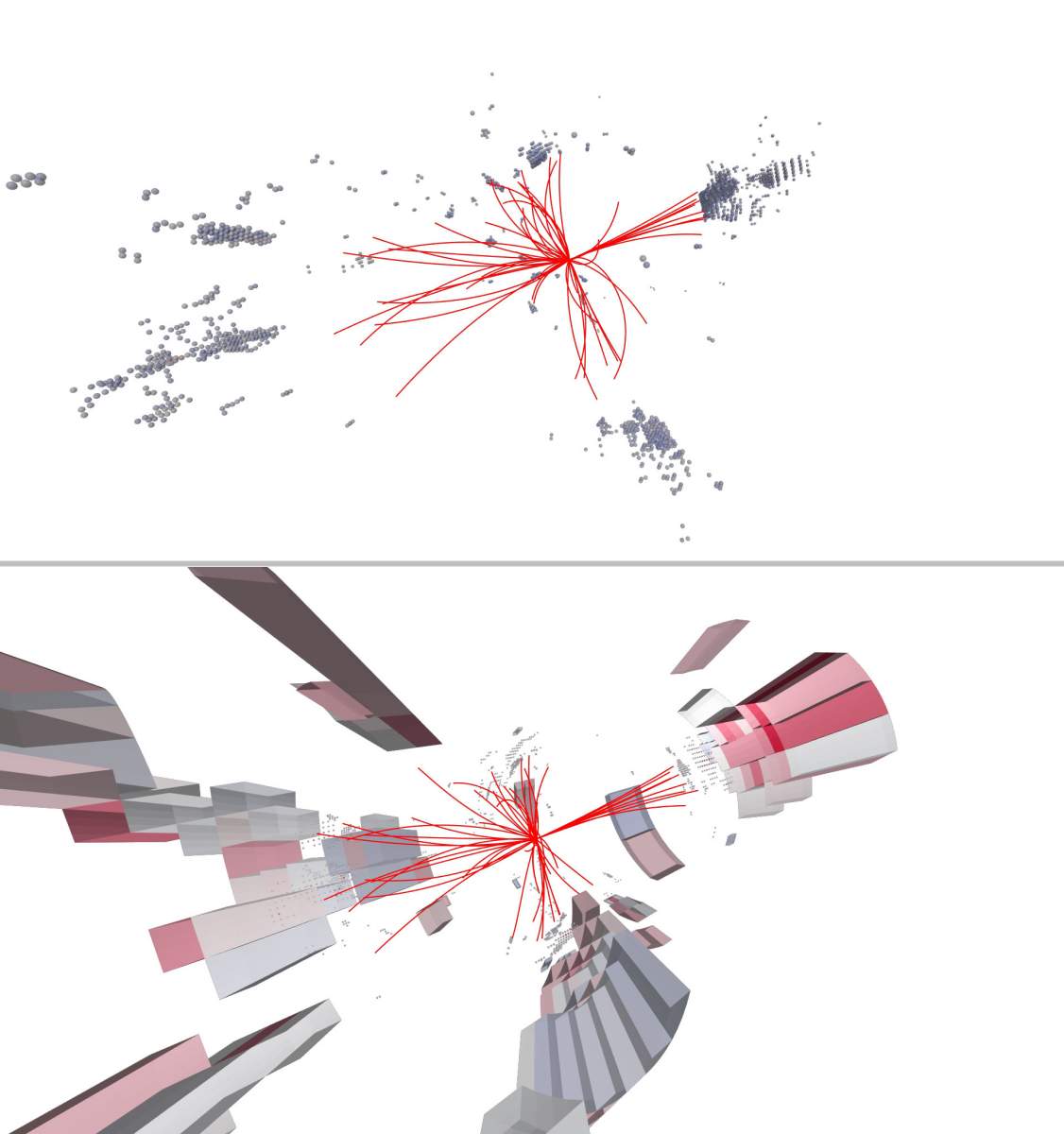

L’utilisation d’une simulation de la collision, comme si elle était détectée par un détecteur plus sensible (image du haut), « apprend » à l’ordinateur, par « deep learning » (apprentissage approfondi), à l’analyser plus efficacement et plus précisément (image du bas). Les lignes rouges indiquent le parcours des particules après la collision.

Le premier défi que l’équipe du Prof. Gross a décidé de relever était d’améliorer la capacité à distinguer différents types de quarks – des particules élémentaires qui peuvent être détectées lorsque des particules plus grandes entrent en collision. On connaît actuellement six types, ou « saveurs », de quarks, chacun ayant sa propre masse distincte qui détermine le type particulier de quark dans lequel un boson de Higgs se désintégrera après une collision. Ainsi, par exemple, la probabilité d’observer un boson de Higgs se désintégrant en un quark « inférieur » (bottom) est très élevée – en raison de sa masse importante – tandis que les quarks « up » (haut) et « bas » (down) sont si légers qu’ils sont pratiquement indétectables. Le quark « charme » , qui n’est ni trop léger ni trop lourd, est difficile à identifier par lui-même, ainsi qu’à distinguer du quark inférieur.

Pour résoudre cette difficulté, le groupe de recherche a mis au point un algorithme de flux de particules qui analyse les schémas de mouvement et de dispersion de l’énergie de ces particules dans le temps et l’espace. En fournissant à l’algorithme des milliards de collisions simulées, les scientifiques ont pu démontrer que l’on peut apprendre à un ordinateur à identifier et à analyser les données pertinentes. « Nous n’avons actuellement pas les moyens de construire des détecteurs plus sensibles », explique M. Gross, « mais comme nous comprenons la physique des collisions de particules, nous pouvons créer des simulations à haute résolution de ces événements afin de nous demander : comment le détecteur réagirait-il s’il était doté de composants supplémentaires qui permettraient de mesurer les collisions avec plus de précision ? »

Prof. Eilam Gross

Prof. Eilam Gross

Maintenant que le Prof. Gross et son équipe ont été en mesure de fournir une preuve de concept pour l’algorithme qu’ils ont développé, la prochaine étape consistera à le tester sur des ensembles de données plus importants. « Nous comprenons aujourd’hui qu’afin de donner une plus grande valeur scientifique aux mesures effectuées au LHC, la sensibilité de nos méthodes d’analyse des données doit être aussi élevée que possible », explique Shlomi. « Les simulations précises sont un outil précieux qui pourrait nous aider à maximiser la sensibilité de la méthode. »

« Je pense que le domaine de la physique des particules dans son ensemble se dirige vers l’intelligence artificielle – à tel point qu’aucun scientifique du futur ne prendrait même la peine de mentionner qu’il s’appuie sur l’apprentissage automatique pour son analyse, car ce serait une évidence, un outil fondamental dans notre boîte à outils », déclare le Prof. Gross. « Nous n’en sommes pas encore là, mais lorsque nous y arriverons, le plus tôt sera le mieux , tout le domaine se transformera et nous assisterons à une révolution dans la façon dont les données de la physique des hautes énergies sont analysées. »

La science en chiffres

Au centre du détecteur ATLAS, environ 1 000 000 000 de protons entrent en collision les uns avec les autres à chaque seconde.

Les recherches du professeur Eilam Gross sont soutenues par le Centre Nella et Leon Benoziyo pour la physique des hautes énergies.